本文由半导体产业纵横(ID:ICVIEWS)编译自techinsights

谷歌悄然成为数据中心处理器领域第三大设计商。

谷歌长期以来一直处于人工智能 (AI) 革命的前沿。机器学习广泛应用于图像识别和分类、语音识别和翻译、推荐引擎以及构成谷歌业务基础的众多活动。该公司从 21 世纪初开始投资机器学习,从 2001 年开始为网络搜索提供拼写建议,并于 2006 年推出谷歌翻译。谷歌在 2010 年代初通过 Brain 项目改变了方向,拥抱了深度学习革命。2014 年,谷歌收购了 DeepMind,成为机器学习研究领域的领先公司。

谷歌人工智能模型最初在 CPU 上运行,利用了庞大的谷歌云基础设施。收购 DeepMind 后,该公司将重点转向 GPU,推动了 NVIDIA 数据中心业务的早期成功。从这一时期开始,很明显机器学习可以服务于所有谷歌业务,并且必须大规模部署以支持搜索、Gmail、YouTube 和 Android 等产品。2013 年,谷歌估计,如果使用 CPU,每天为每个 Android 用户进行三分钟的语音识别将需要其计算基础设施扩大四倍,因此在经济上不可行。转向 NVIDIA GPU 或 Xilinx/Altera FPGA 等加速器可能会更具成本效益,但会产生不可接受的战略依赖性。

谷歌选择了一种定制的硅片解决方案,并于 2013 年组建了一支顶尖团队,利用 RISC 处理器和脉动系统方面的学术研究成果,实现矢量/矩阵数学加速。第一个张量积单元 (TPU) 于 2015 年秘密发布,距离项目启动仅 15 个月。虽然第一款产品没有使用最新的技术平台或最快的时钟速度,但它功能齐全且具有成本效益——这是一项了不起的成就。2016 年,DeepMind 展示了 TPU 的价值,大幅降低了其突破性 AlphaGo Zero 模型的训练成本。最初的 TPU旨在提供具有成本效益的大规模推理,但缺乏掌握 AI 模型训练的功能。谷歌仅发布了几千款产品,并于 2017 年推出了第二代,2018 年底又推出了第三代。第四代 TPU 在许多 MLPerf 基准测试(最显著的是深度学习和卷积网络)上超越了竞争对手,同时在谷歌自主研发的 BERT 等大型语言模型方面与 NVIDIA 的领先产品(A100)相媲美。

Google 不发货 TPU;这一公开部分在 TechInsights 的公共云发货量、已安装基数和市场规模预测报告中有详细记录。然而,从这份介绍中可以清楚地看出,Google 使用大多数 TPU 来支持自己的服务,并且没有动力公开其基础设施的实际规模。

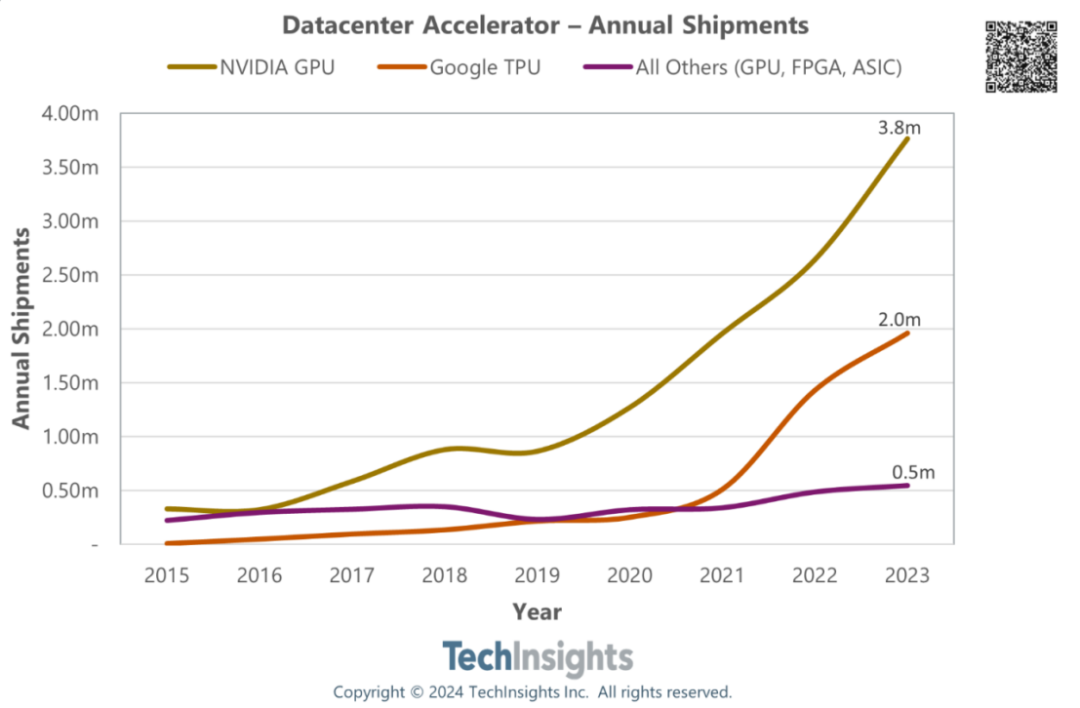

研究表明,随着公司的发展,谷歌的出货量随着每一代新 TPU 的推出而加速。随着 TPU v4 和大型语言模型的出现,谷歌芯片业务的规模显著增加(图 1),使其主要 ASIC 合作伙伴博通受益。为了说明谷歌在数据中心加速器市场的影响力,TechInsights研究了数据中心计算处理器 2024 年第一季度数据中心加速器的年度出货量。

图 1:数据中心加速器年度出货量2015 年至 2023 年

相对于公司在数据中心市场的规模,谷歌 ASIC 的出货量明显更高。谷歌的策略是使用 TPU 来处理内部工作负载,使用 NVIDIA GPU 来处理云计算,TechInsights认为谷歌拥有整个行业最大的 AI 加速器安装基数和最大的 AI 计算基础设施。

谷歌悄然成为数据中心处理器领域第三大设计商

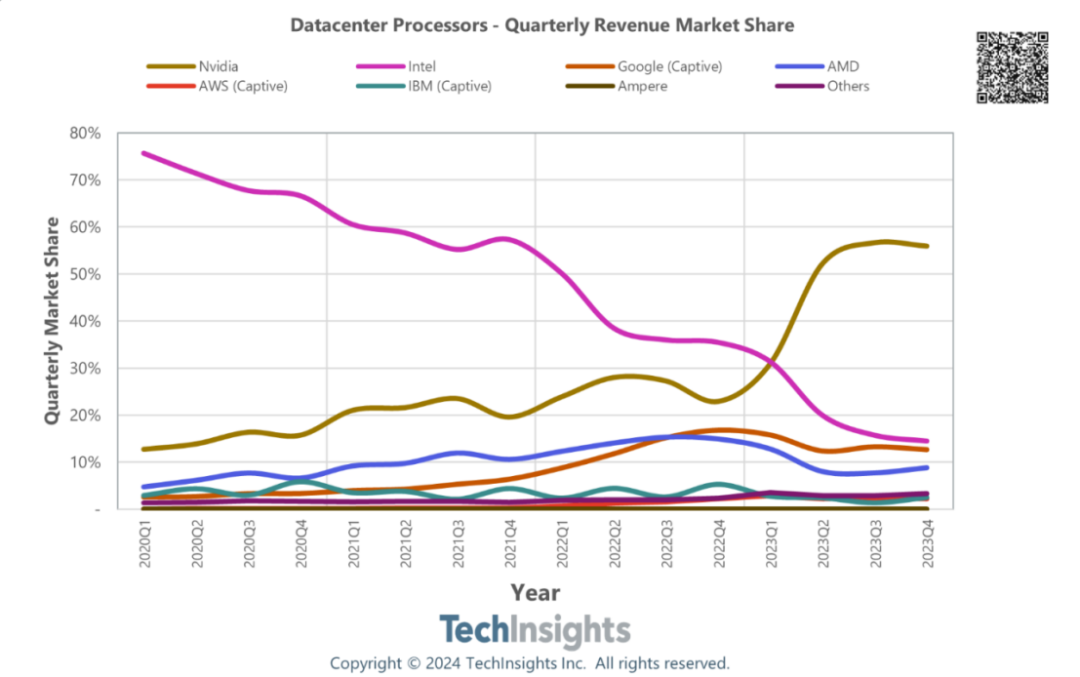

尽管 Google 不销售芯片,但其自有生产是整个市场的一部分,并取代了 CPU、GPU 或 FPGA 等替代品。通过以公平市场价格为 TPU 定价来核算 Google ASIC 收入。这样的呈现更好地反映了谷歌在行业中的地位,并提供了更强有力的方法来捕捉市场趋势,因为越来越多的参与者选择定制硅片解决方案(例如,AWS、微软、Meta、苹果)。

那么,谷歌是什么时候成为领先的芯片公司的?2023 年,服务器市场经历了大规模的库存调整,因为超大规模服务器正在延长其安装基数的使用寿命(延长摊销期),并将更多资本支出分配给加速服务器和 NVIDIA H100。内部处理器的推出不遵循季节性模式,也不容易出现库存调整。当 AMD 和英特尔的市场份额在 2023 年上半年暴跌时,谷歌正在超越前者并追赶后者。

图 2:2020 年第一季度至 2023 年第四季度数据中心计算处理器市场

谷歌的芯片业务正在加速发展

随着大型语言模型(如谷歌的 Gemini)和混合 AI 计算的爆炸式增长,预计谷歌第五代TPU产品将比之前的版本得到更广泛的部署,谷歌将继续推动数据中心 ASIC 市场的发展。

此外,TPU 只是故事的一部分。今年,谷歌还宣布计划以基于 Arm Neoverse 架构的定制设计进入数据中心 CPU 市场,复制亚马逊的 AWS Graviton 战略。根据 TechInsights 的云研究,2023 年,AWS 向其客户出租了相当于 230 万个处理器,其中 Graviton 占 17%,超过了该平台上 AMD 芯片的使用量。预计 Google Axion 的增长速度将快于 Graviton;软件基础设施随时可用。

谷歌推出定制 CPU 是该公司芯片业务的下一步。这也是与 AWS、微软以及阿里巴巴(程度较小)保持同步的必要举措——它们都拥有自主研发的微处理器和加速器芯片。此类战略举措正在改变数据中心半导体竞争,对台积电、博通、Marvell 或 AlChip 等设计和供应链合作伙伴来说是一个福音。

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系后台。